En un giro inesperado para el sector tecnológico, un estudio reciente ha demostrado que las herramientas de inteligencia artificial diseñadas para acelerar la programación pueden en realidad ralentizar el trabajo de desarrolladores experimentados.

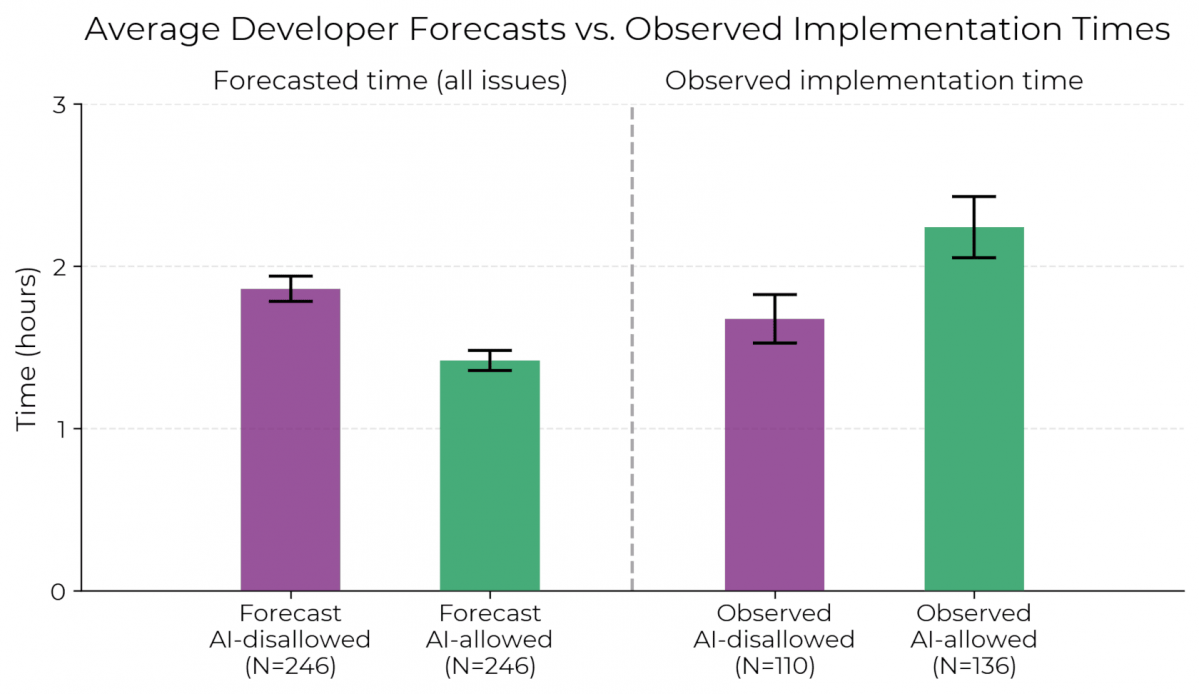

El informe, realizado por la organización sin ánimo de lucro Model Evaluation and Threat Research (METR), concluyó que los ingenieros de software tardaron un 19 por ciento más en completar tareas reales cuando utilizaron asistentes de código basados en IA como Cursor Pro con modelos de lenguaje de última generación como Claude 3.5 y 3.7 Sonnet.

METR es una organización sin ánimo de lucro fundada en Berkeley en 2022 por Beth Barnes, exmiembro de OpenAI. Su misión es evaluar la seguridad y capacidades de los modelos avanzados de IA, lo que inlcuye sus efectos en entornos laborales reales.

Su investigación —llevada a cabo entre febrero y junio de 2025— observó a 16 desarrolladores trabajando en proyectos de código abierto complejos, cada uno con más de un millón de líneas de código. A través de un ensayo controlado y aleatorio, se midió su desempeño en 246 tareas específicas, comparando resultados con y sin el uso de IA.

Sorprendentemente, los desarrolladores que contaban con herramientas de IA no solo trabajaron más lento, sino que además creían estar siendo más productivos: estimaban haber acelerado su trabajo en un 20 por ciento, pese a los datos objetivos que indicaban lo contrario.

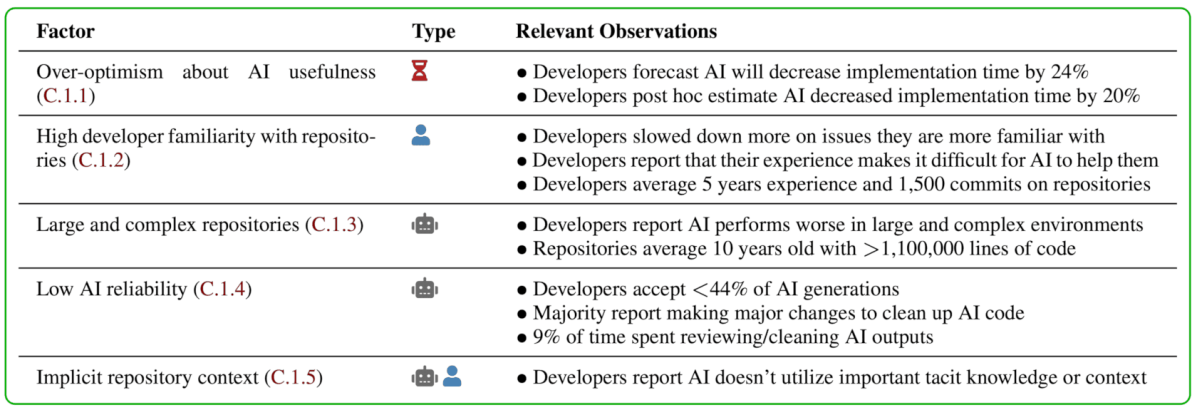

Según el análisis de METR, varios factores contribuyeron al deterioro del rendimiento:

Hay que señalar que este estudio no se diseñó para evaluar a desarrolladores novatos ni para proyectos nuevos. Al contrario, se centró en profesionales con más de cinco años de experiencia que trabajaban en bases de código que conocían a fondo.

La conclusión, según METR, es clara: “Los asistentes de codificación con IA pueden no ser útiles —e incluso ser perjudiciales— en entornos donde el conocimiento profundo del código y la precisión son críticos”.

Aunque estos resultados contrastan con estudios previos —como los realizados por GitHub o Google, donde se documentaron mejoras de hasta un 56 por ciento en tareas simples—, la diferencia parece deberse a la complejidad del entorno real y la experiencia de los usuarios.

Los experimentos anteriores se hicieron en contextos controlados, sobre tareas nuevas y aisladas, mientras que el de METR se centró en flujo de trabajo profesional continuo.

A pesar de los resultados, muchos participantes afirmaron que preferían usar las herramientas de IA porque “hacen que el trabajo sea más llevadero” y “menos agotador cognitivamente”.

METR advierte de que los modelos de IA están evolucionando rápidamente, por lo que estos efectos negativos podrían desaparecer en los próximos meses. Además, el informe recomienda evaluar cuidadosamente el uso de IA en equipos técnicos: más allá de la percepción subjetiva de velocidad, es crucial medir objetivamente el impacto real en la productividad.