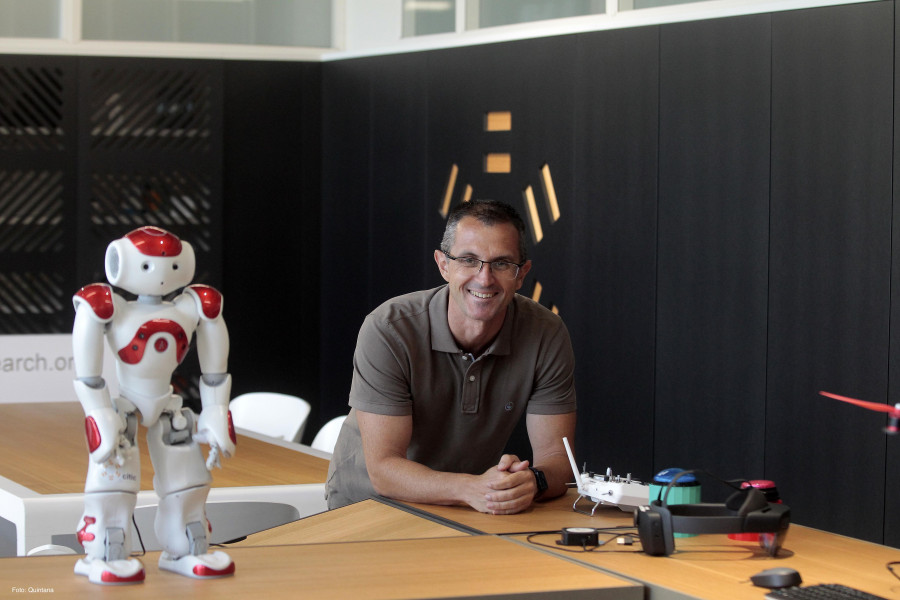

El investigador y catedrático de la Universidad de A Coruña Francisco Javier Bellas Bouza (Ferrol, 1975) lleva años profundizando en cómo mejorar la educación digital. No obstante, la prácticamente repentina llegada de la inteligencia artificial (IA) a la cotidianidad de la sociedad hace que muchos de nosotros nos acostumbremos a trabajar con ella –muchas veces de forma inconsciente–, con los riesgos que eso conlleva. Tras liderar un informe pionero sobre Inteligencia Artificial Explicable (XAI) en el ámbito educativo, se llegó a la conclusión de que esta tecnología debe incluir explicaciones personalizadas para ser fiable.

¿En qué consiste el informe?

Básicamente estamos en un momento en el que la IA, tanto el ChatGPT como muchas otras aplicaciones, está empezando a afectar a todo el mundo. Antes era una cuestión más técnica pero ahora en todos los sectores empiezan a hacer uso de las herramientas y el problema que tienen es que hacen cosas pero no te explican por qué. Estuvimos trabajando durante cuatro meses para ver cómo afectaba a profesores, estudiantes y demás. El informe analiza por qué es importante dar buenas explicaciones. Además, se dan recomendaciones de cómo se debe utilizar para que las tecnologías les puedan dar esa explicación.

Es necesario tener un mínimo de conocimiento.

Por supuesto. Que la IA es el futuro (y ya presente) no me cabe la menor duda. Es importante decir que cuando hablamos de IA no solo hablamos de ChatGPT. En Estados Unidos, por ejemplo, la conducción autónoma es legal. Cuando el coche te diga que va a parar en un sitio tú deberías preguntarle por qué y él te debería dar algún motivo. Parecen tonterías pero no lo son tanto. Si no entendemos por qué la inteligencia artificial hace lo que hace, entonces estamos vendidos y perdemos el control. En el informe hablamos de la actitud crítica, es decir, por qué te lo dice. En educación, sobre todo, pasa mucho.

“Lo que hay que hacer para usar estas herramientas es comprender lo que hacen y sus limitaciones

¿Hay poca educación digital?

Lo primero que hay que hacer para poder usar estas herramientas es comprender lo que hacen y sus limitaciones. En informática siempre se dejó un poco como una asignatura de segunda división y la realidad es que al llegar a casa siempre la utilizas. La importancia que tiene el saber utilizar las herramientas es mucha. Tanto profesores como estudiantes tienen que formarse en qué es esto de la IA y cómo les impacta. Si tú te formas, empezarás a hacer preguntas de por qué funciona y por qué no. Aprender esta tecnología es clave ahora mismo.

¿Quién se ve más afectado?

Donde más se nota el uso de esta IA es en trabajos que los alumnos hacen desde sus casas con el ordenador. Tú no puedes evitar que el alumno lo haga, de hecho, es ilegal utilizar herramientas para corregir. Por tanto, primero es el profesor el que tiene que aprender el impacto que tiene. El estudiante tiene que aprender a usarlo, pero no para este tipo de cosas. En la Universidad creemos que es importante porque les va a suponer una ventaja de cara al mundo laboral. Tienen que aprender a usarla porque les va a hacer falta para la vida.